Tin tức

Robots TXT Là Gì? Thông Tin Quan Trọng Về File Robots TXT

Một trong những yếu tố không thể thiếu để đảm bảo website của bạn hoạt động hiệu quả trên các công cụ tìm kiếm chính là file Robots TXT. Vậy, Robots TXT là gì và tại sao nó lại giữ vai trò quan trọng? Bài viết này, thegioiweb.com.vn sẽ giúp bạn tìm hiểu chi tiết về Robots TXT, cũng như cách tạo và sử dụng nó để tối ưu hóa website của mình.

Tìm hiểu cụ thể Robots TXT là gì?

Robots TXT chính là một tệp văn bản có định dạng .txt được sử dụng để hướng dẫn các công cụ tìm kiếm về cách thu thập dữ liệu trên website của bạn. Tệp này chứa những chỉ dẫn quan trọng giúp xác định các phần của website mà bạn muốn hoặc không muốn các công cụ tìm kiếm thu thập và lập chỉ mục.

Được đặt tại thư mục gốc của website, file Robots TXT chính là một phương thức giao tiếp giữa website và các con bot tìm kiếm. Khi một công cụ tìm kiếm như Googlebot hoặc Bingbot truy cập vào website của bạn, file Robots TXT sẽ cung cấp thông tin về những trang, thư mục nào có thể hoặc không thể được thu thập dữ liệu.

Thông qua việc tìm hiểu Robots TXT là gì, bạn có thể kiểm soát những gì các công cụ tìm kiếm được phép làm với nội dung trên trang. Từ đó, giúp bạn tối ưu hóa việc xuất hiện trên các trang kết quả tìm kiếm một cách hiệu quả.

Thuật ngữ phổ biến trong file Robots TXT

Để hiểu rõ hơn về cách hoạt động của Robots TXT là gì, bạn cần nắm vững các thuật ngữ phổ biến trong tệp này.

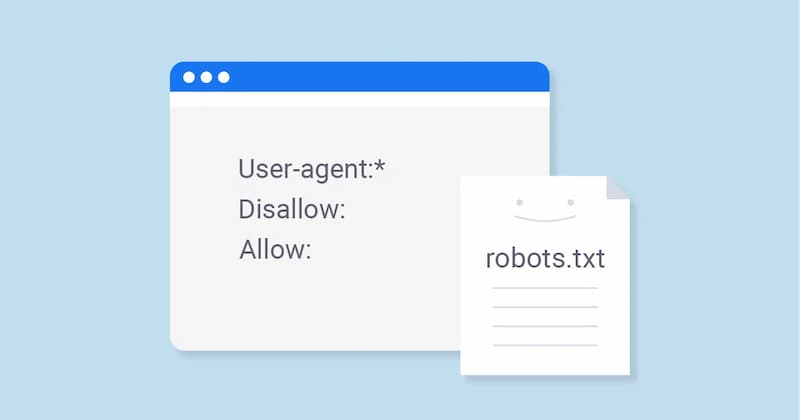

User-agent

Phần này là tên của các trình thu thập, truy cập dữ liệu web, hay còn gọi là các bot tìm kiếm (ví dụ: Googlebot, Slurp, Bingbot,…). Mỗi trình thu thập dữ liệu sẽ được định danh riêng biệt trong file Robots TXT. Khi một công cụ tìm kiếm truy cập vào website của bạn, nó sẽ kiểm tra phần User-agent để biết mình có quyền truy cập vào những phần nào của website hay không.

Disallow trong Robots TXT là gì?

Lệnh Disallow được sử dụng để thông báo cho các User-agent không thu thập dữ liệu từ một URL cụ thể nào. Mỗi URL chỉ có thể được chỉ định một dòng Disallow. Ví dụ, nếu bạn không muốn Googlebot thu thập dữ liệu từ một trang nhất định, có thể chỉ định URL đó trong file Robots TXT với lệnh Disallow.

Allow

Lệnh Allow chỉ áp dụng cho Googlebot và thông báo rằng Googlebot có thể truy cập vào trang hoặc thư mục con mặc dù các phần khác có thể bị cấm. Khi tìm hiểu Robots TXT là gì bạn sẽ rõ đây là một cách để chỉ định ngoại lệ trong trường hợp bạn muốn Googlebot truy cập vào một phần cụ thể mà không bị ảnh hưởng bởi các lệnh Disallow.

Crawl-delay

Lệnh Crawl-delay được sử dụng để thông báo cho các bot web biết rằng chúng phải đợi bao nhiêu giây trước khi tải và thu thập nội dung của một trang. Tuy nhiên, lưu ý rằng Googlebot không thừa nhận lệnh này và bạn có thể điều chỉnh tốc độ thu thập dữ liệu trong Google Search Console.

Sitemap

Lệnh Sitemap trong Robots TXT là gì? Chúng cung cấp các vị trí của bất kỳ Sitemap XML nào được liên kết với URL này. Lệnh này giúp các công cụ tìm kiếm như Google, Bing và Yahoo dễ dàng tìm thấy và thu thập dữ liệu từ các Sitemap trên website của bạn.

Robots TXT hoạt động ra sao?

Khi một công cụ tìm kiếm muốn thu thập dữ liệu từ một website, nó sẽ bắt đầu bằng việc truy cập vào các trang của website đó thông qua các liên kết. Quá trình này được gọi là Crawl (cào dữ liệu) và nó giúp các công cụ tìm kiếm khám phá tất cả nội dung có sẵn trên website.

Để thực hiện nhiệm vụ này, công cụ tìm kiếm sử dụng các con bot, còn được gọi là Web Crawlers hoặc Spiders, để quét và thu thập dữ liệu từ các trang web. Trước khi bắt đầu quá trình Crawl, các con bot sẽ tìm kiếm file Robots TXT trên website. Nếu file này tồn tại, các bot sẽ đọc nội dung trong file trước khi tiếp tục thu thập dữ liệu.

Nghiên cứu Robots TXT là gì, bạn biết file sẽ chứa các chỉ dẫn về cách mà các công cụ tìm kiếm nên thu thập dữ liệu từ website của bạn. Nếu không có chỉ dẫn rõ ràng trong file này, các công cụ tìm kiếm sẽ tiếp tục thu thập dữ liệu một cách tự do, mà không có sự hạn chế nào.

Một ví dụ, nếu bạn có một trang web bán hàng nhưng không muốn các công cụ tìm kiếm lập chỉ mục một số trang như trang giỏ hàng hoặc trang thanh toán,. Bạn có thể sử dụng lệnh Disallow trong Robots TXT để yêu cầu các bot không thu thập dữ liệu từ những trang này.

Hướng dẫn cách tạo file Robots TXT trên WordPress đơn giản

Tạo một file Robots TXT là gì trên WordPress không quá phức tạp và dưới đây là một số cách đơn giản để bạn có thể thực hiện.

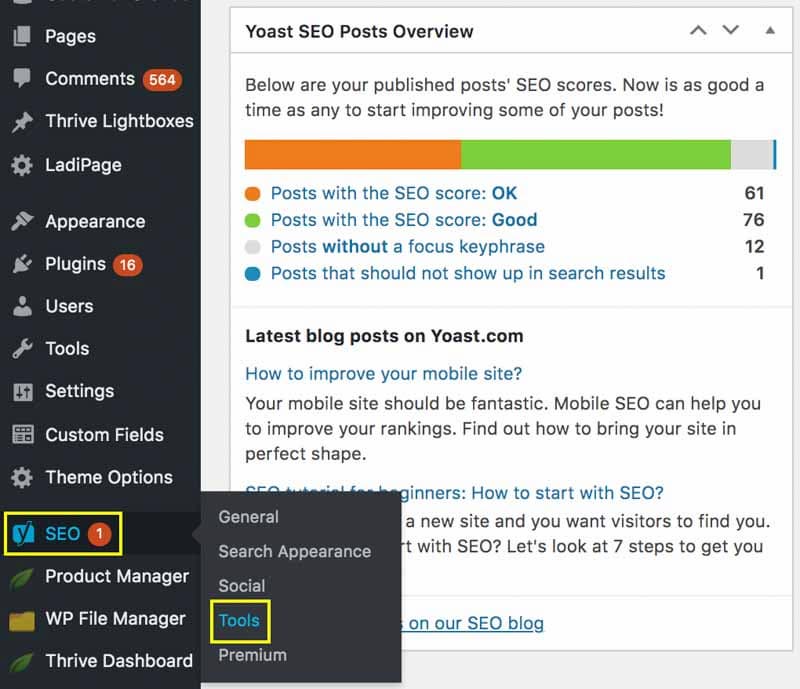

Dùng Yoast SEO để tạo file Robots TXT

Yoast SEO trong Robots TXT là gì? Đây là một trong các plugin SEO phổ biến nhất trên nền tảng WordPress. Với Yoast SEO, việc tạo file Robots TXT trở nên vô cùng đơn giản. Đây là cách thức phù hợp cho những người mới bắt đầu với SEO hoặc những ai muốn quản lý SEO cho website WordPress của mình một cách nhanh chóng.

- Cài đặt Yoast SEO: Đầu tiên, bạn cần cài đặt và kích hoạt plugin Yoast SEO trên trang WordPress của mình. Để làm điều này, bạn hãy vào bảng điều khiển WordPress => Plugin => Thêm mới, tìm kiếm “Yoast SEO” và cài đặt.

- Đi tới phần công cụ SEO: Sau khi cài đặt và kích hoạt Yoast SEO, bạn vào SEO trong menu bên trái, sau đó chọn “Công cụ”.

- Chỉnh sửa file Robots TXT: Trong phần “Công cụ”, bạn sẽ thấy mục “File robots.txt”. Tại đây, bạn có thể chỉnh sửa file này để thêm các chỉ thị cần thiết cho các công cụ tìm kiếm. Nếu file Robots TXT chưa tồn tại, Yoast SEO sẽ tự động tạo ra một file mới cho bạn.

- Lưu và kiểm tra: Sau khi chỉnh sửa file, đừng quên lưu lại và kiểm tra bằng cách truy cập vào website của mình và thêm “/robots.txt” vào cuối URL (ví dụ: www.yoursite.com/robots.txt) để đảm bảo file đã được tạo thành công.

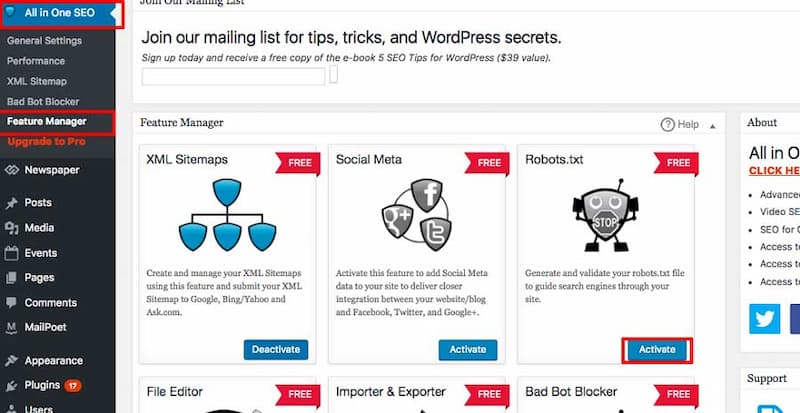

Sử dụng triệt để bộ Plugin All in One SEO

Một plugin SEO khác mà bạn có thể sử dụng để tạo file khi nghiên cứu Robots TXT trên WordPress, chính là All in One SEO. Đây là một công cụ tối ưu hóa SEO toàn diện, hỗ trợ nhiều tính năng, bao gồm cả việc tạo và chỉnh sửa file Robots TXT.

- Cài đặt All in One SEO: Tương tự như Yoast SEO, bạn cần cài đặt và kích hoạt All in One SEO từ kho plugin WordPress. Chỉ cần vào Bảng điều khiển WordPress => Plugin => Thêm mới, tìm kiếm “All in One SEO” và cài đặt.

- Đi đến phần SEO: Sau khi cài đặt, bạn sẽ thấy một menu mới có tên “All in One SEO”. Bạn chỉ việc vào đó và chọn “Công cụ”.

- Chỉnh sửa file Robots TXT: Trong phần “Công cụ”, bạn sẽ thấy mục “Robots.txt”. Tại đây, bạn có thể dễ dàng tạo mới hoặc chỉnh sửa file Robots TXT của mình. Cũng giống như Yoast SEO, bạn có thể thêm các chỉ thị để yêu cầu các công cụ tìm kiếm truy cập hoặc không truy cập vào các phần cụ thể của website.

- Kiểm tra và lưu lại: Sau khi chỉnh sửa xong, bạn đừng quên lưu lại và kiểm tra URL của file Robots TXT để chắc chắn rằng nó đã được cập nhật chính xác.

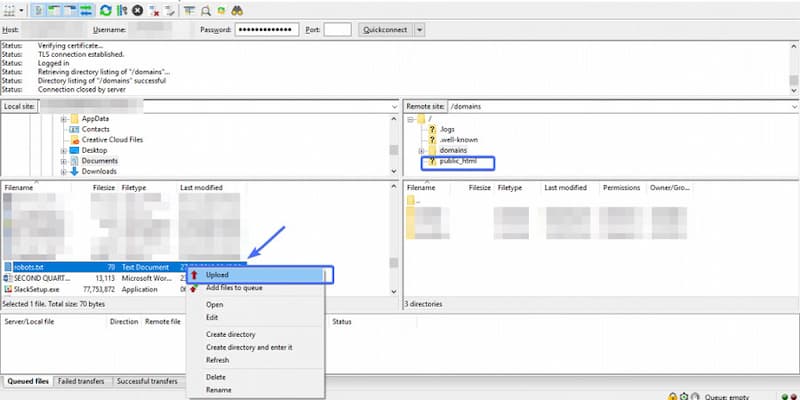

Tạo và Upload File Robots TXT qua hệ thống FTP

Ngoài việc sử dụng các plugin, bạn cũng có thể tạo và upload file Robots TXT một cách thủ công thông qua FTP. Đây là một phương pháp dành cho những ai đã có kinh nghiệm với quản lý website và muốn tự tay chỉnh sửa file này mà không cần sử dụng plugin.

- Tạo file Robots TXT trên máy tính: Trước tiên, bạn cần tạo một file Robots TXT trên máy tính của mình. Bạn có thể sử dụng bất kỳ trình soạn thảo văn bản nào như Notepad trên Windows hoặc TextEdit trên Mac. Sau khi tạo xong, bạn hãy lưu file dưới dạng Robots.txt.

- Sử dụng FTP để kết nối với website: Để upload file Robots TXT lên website, bạn cần một phần mềm FTP như FileZilla. Sử dụng FTP để kết nối với máy chủ web của bạn bằng thông tin đăng nhập FTP mà nhà cung cấp hosting cung cấp.

- Upload file Robots TXT vào thư mục gốc: Sau khi kết nối thành công, bạn hãy điều hướng đến thư mục gốc public_html hoặc www của website và upload file Robot TXT vào đây.

- Kiểm tra và xác nhận: Sau khi upload file Robot TXT, bạn có thể kiểm tra lại bằng cách truy cập vào URL của website và thêm “/robots.txt” vào cuối địa chỉ (ví dụ: www.yoursite.com/robots.txt). Nếu mọi thứ đã được thực hiện đúng, bạn sẽ thấy nội dung file Robots TXT mà bạn vừa tải lên.

Việc hiểu rõ và áp dụng đúng cách về Robots TXT là gì rất quan trọng để tối ưu hóa website của bạn trên các công cụ tìm kiếm. Nó giúp bạn kiểm soát việc thu thập dữ liệu từ các bot tìm kiếm và đảm bảo rằng nội dung của bạn được lập chỉ mục một cách hợp lý. Nếu bạn chưa tạo file Robots TXT cho website của mình, hãy tham khảo hướng dẫn trên để thực hiện ngay hôm nay.

Để nhận thêm sự hỗ trợ về việc thiết kế website tối ưu cho doanh nghiệp, hãy ghé thăm thegioiweb.com.vn, nơi cung cấp các giải pháp thiết kế web chuyên nghiệp và hiệu quả.

CEO Mai Thúy Hằng là người sáng lập và lãnh đạo thegioiweb.com.vn, một nền tảng hàng đầu về thiết kế website và marketing trực tuyến tại Việt Nam. Với kinh nghiệm dày dạn trong lĩnh vực công nghệ thông tin và marketing, cô đã dẫn dắt đội ngũ thegioiweb phát triển những giải pháp sáng tạo, giúp các doanh nghiệp khẳng định thương hiệu trong thế giới số. Với tầm nhìn chiến lược và sự đam mê với công nghệ, Mai Thúy Hằng không chỉ là một nhà lãnh đạo xuất sắc mà còn là một người truyền cảm hứng cho đội ngũ của mình. Cô tin rằng mỗi doanh nghiệp đều có tiềm năng riêng và nhiệm vụ của thegioiweb.com.vn là giúp khách hàng khai thác tối đa tiềm năng đó trong thế giới số ngày càng cạnh tranh.

#ceothegioiwebcomvn #adminthegioiwebcomvn #ceomaithuyhang #authorthegioiwebcomvn

Thông tin liên hệ:

- Website: https://thegioiweb.com.vn/

- Email: maithuyhang.thegioiweb@gmail.com

- Địa chỉ: 41 Tống Văn Trân, Phường 5, Quận 11, Hồ Chí Minh, Việt Nam